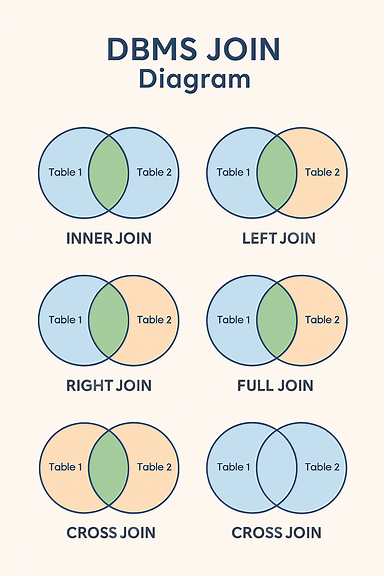

[BigData의 Join 기초]- DBMS Join- Large DB (데이터베이스)의 Hash Join- Large DB (데이터베이스)의 Nested Loop Join- Large DB (데이터베이스)의 Sort-Merge Join DBMS의 Join은 여러 테이블을 연결해 하나의 결과로 보여주는 SQL 기능으로, 공통된 컬럼(조인 키)을 기준으로 데이터를 결합합니다. 대표적으로 INNER JOIN, LEFT JOIN, RIGHT JOIN, FULL OUTER JOIN 등이 있습니다. 🔍 JOIN의 개념정의: 두 개 이상의 테이블을 연결하여 관련 데이터를 하나의 결과로 조회하는 SQL 기능목적:정규화된 테이블을 분석/조회 목적에 맞게 통합중복 없이 정확한 데이터 연결업무 로직에 맞는 데이터 집합 ..