[인공지능 GPT를 이해하는데 알아야 하는 용어들]

- GPT(Generative Pre-trained Transformer)

- LangChain

- LLM (Large Language Model, 거대 언어 모델)

- Vector Embedding(벡터 임베딩)

- Vector Database (벡터 데이터베이스)

- Tokenize (토큰화)

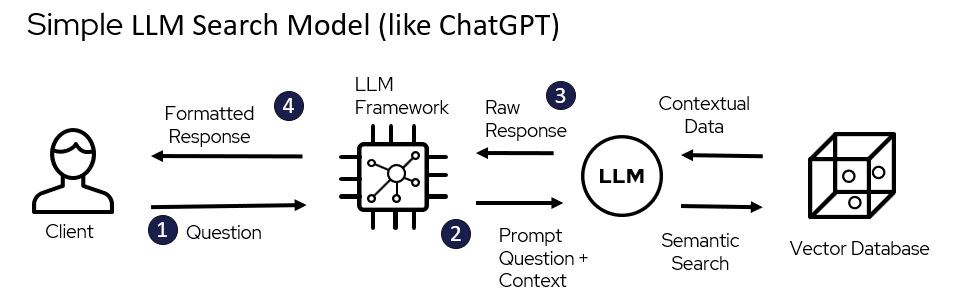

사용자가 GPT를 이용하는 과정을 심플하게 이해하기

GPT에 대한 내용보다 작동되는 과정을 이해하고 어떻게 하면 만들수 있을까를 고민하면서 업데이트를 하고 있습니다. 조금씩 발전 하는 오늘이 되는데 보탬이 되면 좋겠습니다.

GPT3.5의 작동 과정

사용자가 GPT를 이용하는 과정을 심플하게 표현하면 질문을 이해하고 학습된 데이터에서 결과를 읽고 답변하는 것입니다.

GPT3.5의 제약은 학습하지 못한 새로운 지식에 대한 질문이나 외부의 데이터를 연결 하는 것이 제공되지 못하는 단점이 있습니다.

RAG (Retrieval-Augmented Generation, 검색증강생성)와 GPT4

기존 GPT3.5는 학습된 데이터로 답변을 하므로 답변의 환각이나 답변을 하지 못하는 경우가 생깁니다.

RAG는 GPT와 외부 정보를 연결하여 외부의 데이터와 지식을 검색하고 연결하여 더욱 정교한 답변을 제공합니다.

GPT4와 같이 외부정보 검색과 이미지나 문서 를 생성하는 기능이 가능해 집니다.

■ GPT(Generative Pre-trained Transformer)

■ LangChain

LangChain은 개발자가 LLM(Large Language Model)을 이용해 엔드투엔드 애플리케이션을 구축할 수 있도록 설계된 강력한 프레임워크입니다.

■ LLM (Large Language Model, 거대 언어 모델)

■ Vector Embedding(벡터 임베딩)

벡터 임베딩(Vector Embedding)은 고차원의 데이터를 저차원의 벡터 공간으로 매핑하는 기술입니다. 이는 주로 자연어 처리 및 기계 학습 분야에서 사용되며, 단어, 문장, 문서 등을 수치로 표현함으로써 모델이 이해하고 처리할 수 있도록 돕습니다.

■ Vector Database (벡터 데이터베이스)

#SingleStoreDB: https://www.singlestore.com/

SingleStoreDB는 실시간 분석과 트랜잭션 처리를 위한 분산형 데이터베이스 시스템입니다. 이는 OLAP(Online Analytical Processing) 및 OLTP(Online Transaction Processing) 작업을 모두 지원하며 빠른 데이터 쿼리 및 처리를 제공합니다.

#Pinecone: https://www.pinecone.io/

Pinecone은 벡터 검색을 위한 특화된 데이터베이스입니다. 주로 벡터 공간에서의 유사성 검색에 사용되며, 대규모 벡터 데이터를 효과적으로 저장하고 검색할 수 있습니다. 주로 인공지능 및 머신러닝 애플리케이션에서 활용됩니다.

#Chroma: https://www.trychroma.com/

Chroma는 그래프 데이터베이스로, 복잡한 관계와 연결성을 갖는 데이터를 효율적으로 저장하고 처리할 수 있습니다. 그래프 데이터 모델을 기반으로 하며, 소셜 네트워크 분석, 지식 그래프, 추천 시스템 등에 사용됩니다.

#Faiss: https://engineering.fb.com/2017/03/29/data-infrastructure/faiss-a-library-for-efficient-similarity-search/

Faiss는 Facebook에서 개발한 벡터 검색 라이브러리로, 대용량의 벡터 데이터에서 빠른 유사성 검색(

Efficient Similarity Search)을 제공합니다. 특히 딥러닝 및 임베딩 기술과 관련된 작업에서 널리 사용되며, 효율적인 벡터 검색을 위한 다양한 알고리즘을 포함하고 있습니다.

■ Tokenize (토큰화)

■ RAG(Retrieval-Augmented Generation, 검색증강생성)

1) Information Retrieval (IR) Step:

2) Generation Step:

RAG의 장점 :

감사합니다. @좋은 하루 되십시요

[인공지능 주가 예측 ]

[BigData] - 인공지능 주식 예측에 적합한 분석 알고리즘의 종류

[BigData] - [인공지능 RAG 주식 예측] 간단하게 GPT LLM을 이용한 주식 예측 프로그램 만들기[BigData] - [인공지능] Meta AI LLaMA 모델을 사용하여 주식 예측 프로그램 만들기

[BigData] - [인공지능] ARIMA -주가 예측 모델: 3-6-9개월 후 AMZN 주가 확인 -

[BigData] - (AI프롬프트) LangChain과 LLM (Large Language Model)이 만드는 생성형 AI(Generative AI)

[인공지능 기초]

[Tech-Trends] - 2025년 주목 받는 생성형 AI 도구들

[Tech-Trends] - AI 챗봇과 AI 에이전트는 무엇이 다를까 ?

[Tech-Trends] - 정말 알아두면 좋은 AI 도구 트렌드 - AI Trending Tools

[BigData] - 인공지능 GPT4와 RAG를 이해하는데 알아야 하는 용어들

[오픈소스 인공지능 GPT기술]

'BigData' 카테고리의 다른 글

| [생성형AI] RAG(Retrieval Augmented Generation)에 대한 초보자 가이드 (53) | 2023.12.14 |

|---|---|

| SQL 데이터 통계 분석을 강화하는 analytics - window functions (183) | 2023.12.05 |

| (기술)인공지능과 빅데이터 분석을 위한 고성능 분산DBMS SingleStoreDB (88) | 2023.11.19 |

| 데이터 과학과 프롬프트 엔지니어링 - SingleStoreDB 를 이용한 벡터(Vector) DB 활용 (99) | 2023.11.07 |

| (AI프롬프트) LangChain과 LLM (Large Language Model)이 만드는 생성형 AI(Generative AI) (77) | 2023.11.07 |

| chatGPT 와 채팅의 연결 (96) | 2023.10.13 |

| chatGPT 환각(Hallucination) 개선을 위한 응답 품질 점검 - Check outputs (75) | 2023.10.09 |