[인공지능 기술] LlamaIndex와 ChatGPT 사용하기 - llama-index

ChatGPT는 방대한 학습 데이터(LLM)를 이용하여 번역, 요약, 설명 등을 할 수 있는 기술이지만 최신의 정보나 특정 도메인의 지식을 설명하지 못하는 경우 RAG( Retrieval Augmented Generation) 방식으로 데이터의 증강이 필요합니다.

LlamaIndex와 ChatGPT를 사용하여 다양한 도메인에 맞게 고급 애플리케이션을 생성할 수 있습니다.

ChatGPT에서 학습되지 않은 이용하여 외부의 데이터를 임베딩하여 검색에 필요한 도메인별 Data를 추가하여 ChatGPT를 이용 할수 있습니다.

이와 같은 방식을 RAG 기술라고 하며 기업은 제품 관련 질문에 대답할 수 있는 강력한 대화형 챗봇을 구축할 수 있습니다. 제품을 판매하는 회사는 제품 설명서, FAQ 및 기타 공개 정보를 사용하여 ChatGPT 기반 봇을 제공 할 수 있습니다.

1) pip를 사용하여 LlamaIndex의 설치

pip install llama-index

2) 라마인덱스 + ChatGPT: 벡터 저장소 인덱스를 빌드하고 쿼리하는 간단한 예제

import os

os.environ["OPENAI_API_KEY"] = '_OPENAI_API_KEY_'

from llama_index import GPTVectorStoreIndex, SimpleDirectoryReader

documents = SimpleDirectoryReader('data').load_data()

index = GPTVectorStoreIndex.from_documents(documents)

# 검색 쿼리:

query_engine = index.as_query_engine()

query_engine.query("<질문_텍스트>?")

# 기본적으로, 데이터는 메모리에 저장됩니다. 디스크에 저장하려면 (./storage 이하):

index.storage_context.persist()

# 재로드:

_from_storage

# 저장 컨텍스트 다시 구성

storage_context = StorageContext.from_defaults(persist_dir='./storage')

# 인덱스 로드

index = load_index_from_storage(storage_context)

LlamaIndex란 무엇인가?

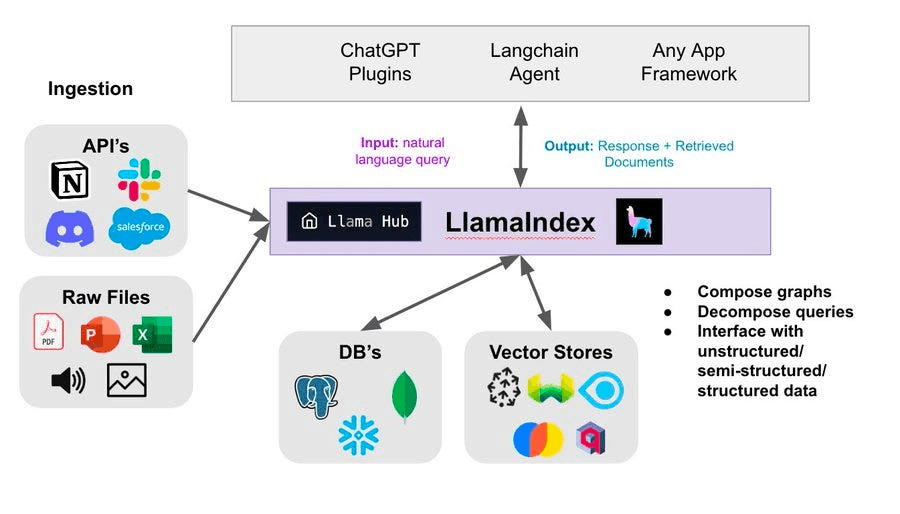

LlamaIndex는 ChatGPT와 같은 대형 언어 모델 (LLM)을 개인 데이터로 강화하기 위해 설계 된 종합적인 데이터 프레임 워크입니다. 개인 데이터 소스에 액세스하여 이러한 모델의 기능을 향상하는 데 도움이됩니다.

LlamaIndex가 ChatGPT와 어떻게 작동하나?

LlamaIndex는 개인 데이터를 가져 오고 구조화하는 도구를 제공하며 데이터에 대한 고급 검색 / 쿼리 인터페이스를 생성하고 외부 응용 프레임 워크와 쉽게 통합 할 수 있도록 지원하여 ChatGPT와 함께 작동합니다.

어떻게 LlamaIndex ChatGPT를 구현할 수 있나?

LlamaIndex를 ChatGPT와 함께 구현하려면 데이터 수집, 적재, 구조화, 쿼리 및 통합과 같은 여러 단계가 필요합니다.

[참고]

https://www.radicalloop.com/blog/simplifying-large-language-models-an-exploration-of-llama-index

https://docs.kanaries.net/ko/topics/ChatGPT/llamaIndex-chatgpt#llamaindex%EC%99%80-chatgpt-%EC%82%AC%EC%9A%A9%ED%95%98%EA%B8%B0

https://docs.kanaries.net/ko/topics/ChatGPT/llamaIndex-chatgpt

'BigData' 카테고리의 다른 글

| [인공지능 RAG 주식 예측] 간단하게 GPT LLM을 이용한 주식 예측 프로그램 만들기 (1) | 2025.02.22 |

|---|---|

| 인공지능 주식 예측에 적합한 분석 알고리즘의 종류 (6) | 2025.01.16 |

| Install SingleStore on Docker : Desktop (27) | 2025.01.14 |

| How to add Firewall rules on Redhat 9 - Allow MySQL Service Through the Firewall (8) | 2024.10.03 |

| MYSQL 계정 생성, 권한부여, 권한 삭제 (5) | 2024.10.03 |

| [인공지능] ARIMA -주가 예측 모델: 3-6-9개월 후 AMZN 주가 확인 - (2) | 2024.08.12 |

| [GPT기술] Llama2 AI모델을 이용한 검색 기술에 활용하기 (122) | 2024.05.22 |